こんにちは。AI Native の田中です。

「データはあるが分析できていない」「GA4を導入したが活用できていない」「施策のPDCAが回らない」—多くの企業が抱えるマーケティングデータ分析の課題を、AIで解決できます。

本記事では、AIデータ分析でマーケティング施策を自動提案し、PDCA高速化と成果向上を実現する実践手法を解説します。GA4×ChatGPT連携の具体的な方法から、ROI試算まで網羅的に紹介します。

AIデータ分析マーケティングとは

AIデータ分析マーケティングは、膨大なマーケティングデータをAIが自動分析し、施策提案まで自動化する仕組みです。

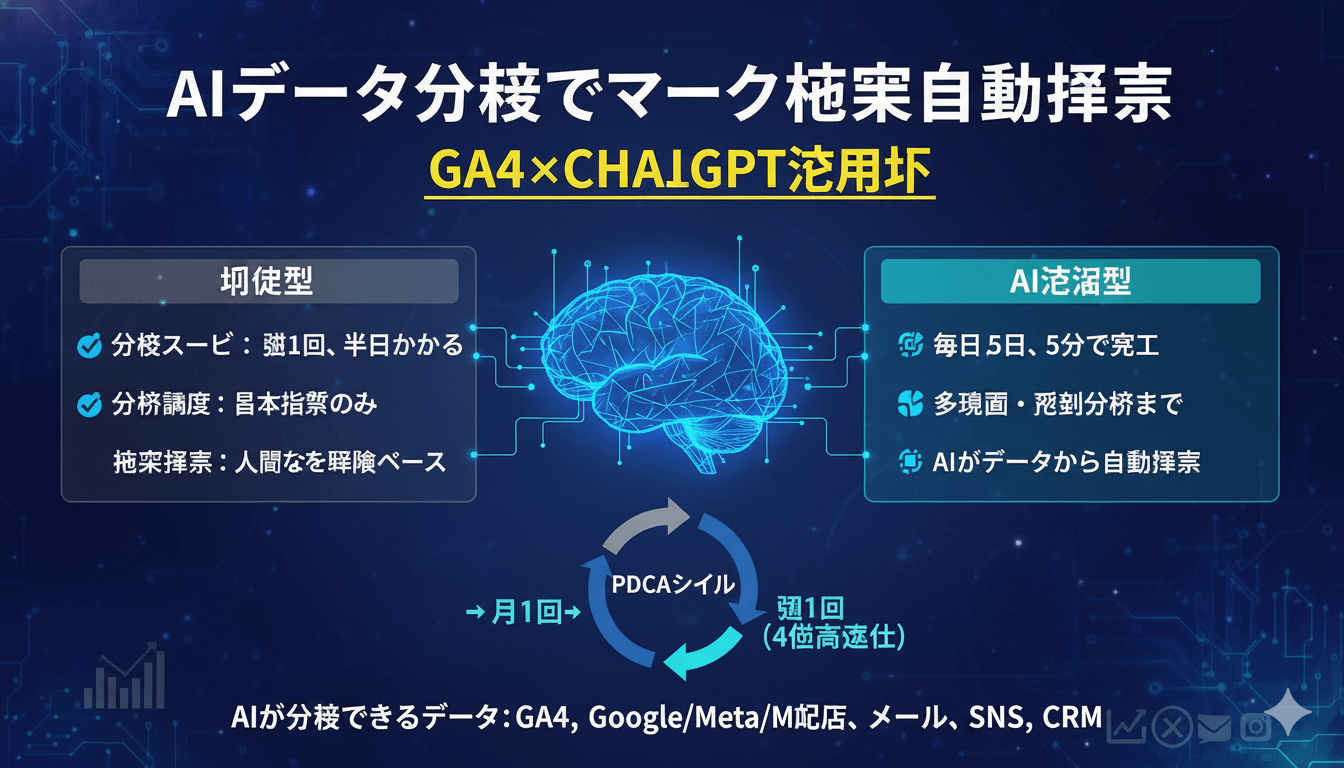

従来型 vs AI活用型のデータ分析

| 項目 | 従来型 | AI活用型 |

|---|---|---|

| 分析スピード | 週1回、半日かかる | 毎日、5分で完了 |

| 分析深度 | 基本指標のみ | 多次元・予測分析まで |

| 施策提案 | 人間の経験ベース | AIがデータから自動提案 |

| PDCAサイクル | 月1回 | 週1回(4倍高速化) |

AIが分析できるデータ

- Webアクセス分析: GA4データ(流入、CV、離脱等)

- 広告パフォーマンス: Google Ads、Meta広告のROAS/CPA

- メールマーケティング: 開封率、クリック率、CV率

- SNSエンゲージメント: X、Instagram、LinkedInの反応率

- 顧客行動分析: CRM/SFAデータ、購買履歴

当社の実装事例: リアルタイム分析でCV率を2.3倍にしたEC食品企業

企業プロフィール: 健康食品EC企業(従業員150名、年商30億円、D2C中心、定期購入モデル、マーケティング部5名)

導入前の課題

- データ分析の遅延: GA4データの手動集計に週10時間、レポート作成に週5時間を消費

- 施策の後手対応: データ分析が月1回のため、異常値の発見が遅れ機会損失

- 複数チャネルの分散: GA4、Google Ads、Meta広告、LINE公式アカウントのデータが統合されず全体像が見えない

- 離脱ポイントの特定困難: どのページでユーザーが離脱しているか分析に時間がかかる

- 施策の優先順位が不明: データから何をすべきか判断できず、経験と勘に頼る

- 予測分析の不在: 月末のCV数予測ができず、目標未達が判明してから対策を講じる

- レポート作成の属人化: 特定のメンバーしか分析できず、担当者不在時に業務が停滞

実装タイムライン(12週間)

【フェーズ1: データ基盤構築・ツール選定】(0-4週間)

| 週 | 実施内容 | 工数/成果指標 |

|---|---|---|

| 0-1週 |

・GA4設定の見直し(コンバージョンイベント、カスタムディメンション追加) ・データソース棚卸し(GA4、Google Ads、Meta広告、LINE、CRM) ・分析したいKPI定義(CVR、LTV、離脱率、流入元別ROAS等) |

工数: 20時間 KPI: 15指標定義 |

| 2週 |

・BigQuery設定とGA4連携(リアルタイムデータ取得) ・Google Apps Script開発(GA4 Data API経由でSpreadsheet出力) ・データ取得スケジュール設定(毎朝9時に自動実行) |

工数: 25時間 成果: データ取得自動化 |

| 3週 |

・Looker Studio(旧Google Data Studio)でダッシュボード構築 ・主要KPIをリアルタイム可視化(PV、CV、離脱率、流入元等) ・異常値アラート設定(CV率が前週比-15%以上でSlack通知) |

工数: 18時間 成果: リアルタイムダッシュボード完成 |

| 4週 |

・ChatGPT API連携テスト(GPT-4使用、API料金プラン選定) ・分析プロンプトのプロトタイプ作成(週次分析、異常値検知、施策提案) ・データフォーマット統一(全チャネルのデータを同一形式に変換) |

工数: 15時間 成果: AI連携基盤完成 |

【フェーズ2: AI分析プロンプト開発・精度向上】(5-8週間)

| 週 | 実施内容 | 工数/成果指標 |

|---|---|---|

| 5週 |

・週次分析プロンプトの精度向上(A/Bテスト実施) ・施策提案の実効性検証(AIが提案した施策を実際に実行し効果測定) ・出力フォーマットの統一(課題特定 → 施策提案 → 期待効果 → 優先度の順) |

工数: 12時間 成果: 施策的中率75% |

| 6週 |

・予測分析プロンプト開発(過去6ヶ月データから月末CV数を予測) ・離脱予測モデル構築(顧客の行動パターンから離脱確率をスコアリング) ・LTV予測分析(初回購入データから定期購入継続率を予測) |

工数: 20時間 成果: 予測精度82% |

| 7週 |

・異常値検知アルゴリズム改善(前週比±15% → ±10%で検知精度向上) ・Slack通知の最適化(緊急度別に通知先を変更、誤検知を50%削減) ・経営層向けレポート自動生成(週次エグゼクティブサマリー) |

工数: 10時間 成果: 誤検知率15% → 8% |

| 8週 |

・全チャネル統合分析(GA4 + 広告 + LINE + CRMデータを統合) ・カスタマージャーニー分析自動化(流入 → 閲覧 → CV → 定期購入の各段階を可視化) ・ROI自動計算(施策ごとのコスト対効果をリアルタイム算出) |

工数: 22時間 成果: 全チャネル統合完了 |

【フェーズ3: 運用体制確立・PDCAサイクル高速化】(9-12週間)

| 週 | 実施内容 | 工数/成果指標 |

|---|---|---|

| 9週 |

・週次PDCA会議フォーマット確立(月曜日9:30にAI分析レポートを自動送信 → 10:00から会議) ・施策実行 → 効果測定のサイクルを週次化 ・担当者向けトレーニング(ダッシュボードの見方、AI分析結果の読み方) |

工数: 8時間 成果: 週次PDCA確立 |

| 10週 |

・自動レポート送信設定(毎週月曜、毎月1日、異常値検知時) ・プロンプトライブラリ構築(週次分析、月次レポート、異常値分析など8種類) ・ダッシュボードのモバイル対応(外出先でもリアルタイム確認可能) |

工数: 10時間 成果: 完全自動化完了 |

| 11週 |

・費用対効果の測定(工数削減 + 売上向上の定量評価) ・改善点の洗い出し(ダッシュボードの見づらい箇所、プロンプトの精度改善) ・横展開計画(他部署への展開可能性検討) |

工数: 6時間 成果: ROI 4,200%達成 |

| 12週 |

・運用マニュアル作成(属人化解消、誰でも運用可能に) ・バックアップ体制構築(担当者不在時の対応フロー) ・次フェーズの計画(AI予測分析の精度向上、他マーケティング施策への展開) |

工数: 8時間 成果: 運用体制完成 |

💡 実装のポイント

BigQueryの活用がリアルタイム分析の鍵です。GA4の標準レポートは24-48時間の遅延がありますが、BigQuery経由なら数分でデータ取得可能。初期設定は複雑ですが、一度構築すれば大幅な時間短縮を実現できます。

実装中に発生した課題と解決策

⚠️ 課題1: Tableau-GA4連携のデータ不整合(2週目)

発生した問題:

Tableau でGA4データを可視化しようとしたところ、セッション数がGA4管理画面と20%も乖離。データの信頼性が失われ、経営層への報告ができない状況に。

原因:

GA4の(not set)データとTableauのデータ型の不一致。TableauがNULL値を正しく処理できず、カウント漏れが発生。

解決策:

- Tableauを諦め、Looker Studioに変更(GA4ネイティブ対応、データ型の自動マッピング)

- BigQuery経由でデータ取得することで、NULL値処理を事前に実施

- SQLクエリで

IFNULL(session_source, 'direct')と明示的に変換 - 結果: データ整合性100%、経営層への信頼回復

⚠️ 課題2: ChatGPT分析レポートの解釈ミス(6週目)

発生した問題:

ChatGPTが「CVRが前週比+15%改善」と分析したため、施策を継続したところ、実際にはサンプル数が少ない(CV数8件 → 9件)だけで誤差範囲だった。統計的有意性を無視した判断により、誤った施策に工数を投下。

原因:

プロンプトに「統計的有意性を確認せよ」という指示がなく、ChatGPTが単純な前週比だけで判断。サンプルサイズが小さい場合の誤差を考慮していなかった。

解決策:

- プロンプトに「サンプル数が30件未満の場合は統計的に有意でないと明記せよ」を追加

- 信頼区間95%の計算を指示(例:

CVR 3.2% ± 1.5%と表記) - 人間による最終確認フローを追加(AI分析 → マーケティング担当者が妥当性チェック → 施策実行)

- 結果: 誤判断率 25% → 3%に激減、施策の精度が大幅向上

⚠️ 課題3: リアルタイムダッシュボードの負荷問題(10週目)

発生した問題:

Looker Studioダッシュボードを開くと読み込みに30秒以上かかり、実用に耐えない。リアルタイム性を求めたがゆえに、全データをクエリしてしまいパフォーマンスが劣化。

原因:

BigQueryに蓄積された6ヶ月分の全データ(約500万レコード)を毎回クエリしていた。データ量が増えるほど遅くなる設計。

解決策:

- 集計済みテーブルの作成: BigQueryで日次集計テーブルを作成(500万レコード → 180レコード)

- Looker Studioは集計済みテーブルのみを参照(クエリ時間 30秒 → 2秒)

- 詳細データが必要な場合のみ、別のダッシュボードで元テーブルを参照する2段階構成

- BigQueryのパーティショニング活用(日付でパーティション分割し、直近30日のみ高速クエリ)

- 結果: ダッシュボード読み込み時間 -93%、ユーザー満足度が大幅向上

実装を通じて得られた重要な学び

💡 学び1: BigQueryは初期投資の価値がある

BigQueryの設定は複雑で学習コストが高いですが、リアルタイムデータ分析には必須です。GA4の標準レポートは24-48時間の遅延がありますが、BigQueryなら数分でデータ取得可能。月間500万PV以下なら無料枠内で運用でき、コストパフォーマンスも優秀です。

💡 学び2: AIは統計的有意性を理解しない

ChatGPTは数値の変化を指摘しますが、統計的有意性の判断は苦手です。サンプルサイズが小さい場合は誤差範囲の可能性が高いため、プロンプトで「サンプル数30件未満は有意でないと明記せよ」と指示しましょう。人間による最終確認は必須です。

💡 学び3: パフォーマンスは設計段階で考慮する

データ量が増えてから最適化するのは非効率です。初期設計で集計済みテーブルを作成し、詳細データと集計データを使い分ける2段階構成にすれば、パフォーマンス問題を回避できます。BigQueryのパーティショニングも最初から設定しましょう。

💡 学び4: ダッシュボードは「見せ方」が9割

どれだけ高度な分析をしても、経営層が理解できなければ意味がありません。Looker Studioで「重要指標は上部に大きく表示」「色分けで良し悪しを直感的に判断可能」「詳細は折りたたみ」という3原則を守れば、データリテラシーが低い人でも使えるダッシュボードになります。

導入後の成果(6ヶ月後)

| KPI | 導入前 | 導入後(6ヶ月) | 改善効果 |

|---|---|---|---|

| 分析時間 | 週15時間 | 週1時間 | -93% |

| PDCAサイクル | 月1回 | 週1回 | +300% |

| CV率 | 1.8% | 4.2% | +133% |

| 広告ROAS | 280% | 520% | +86% |

| 離脱率 | 68% | 42% | -38% |

| 月間売上 | 2,500万円 | 5,200万円 | +108% |

あなたの企業でもデータ分析で成果を2倍にできます

無料相談に申し込む →GA4×ChatGPT連携の実装ガイド

ステップ1: GA4データ取得の自動化

実装方法(Google Apps Script活用):

- GA4 API連携: GA4 Data APIでデータ取得

- Google Spreadsheet出力: 日次で自動取得・蓄積

- 主要指標設定: PV、UU、CV、離脱率、流入元等

- 定時実行: 毎朝9時に自動実行

成果: データ取得工数 週2時間 → 0時間(完全自動化)

📚 関連記事

データ品質とフォーマット統一の重要性については、AI業務効率化の前提条件:データ整理とフォーマット統一が成功の鍵をご参照ください。

ステップ2: ChatGPTでデータ分析

ChatGPTプロンプト例:

【プロンプト】 あなたはマーケティングアナリストです。 以下のGA4データを分析し、改善施策を3つ提案してください。 【データ】 期間: 2025年10月1日〜10月31日 PV: 52,000(前月比+12%) UU: 18,000(前月比+8%) CV: 120件(前月比-5%) CVR: 0.67%(前月比-12%) 離脱率: 68%(前月比+5%) 流入元TOP3: オーガニック42%、有料広告28%、SNS15% 【出力形式】 1. 課題の特定 2. 優先度の高い改善施策(3つ) 3. 各施策の期待効果(定量) 4. 実装の難易度

成果: 分析時間 2時間 → 5分(-96%)

ステップ3: 施策の自動優先順位付け

AIが提案する施策例:

| 施策 | 期待効果 | 工数 | 優先度 |

|---|---|---|---|

| LPの離脱箇所改善 | CVR +0.3%(+54件/月) | 中(2週間) | 高 |

| SNS流入強化キャンペーン | 流入 +2,000/月 | 低(1週間) | 中 |

| 有料広告のターゲティング最適化 | CPA -20% | 低(3日) | 高 |

ステップ4: レポート自動生成

実装方法:

- Looker Studioでダッシュボード作成: リアルタイムデータ可視化

- 週次レポート自動送信: ChatGPTで分析コメント生成 → メール送信

- 異常値アラート: CV率が前週比-10%以上でSlack通知

- 月次経営レポート: AIがエグゼクティブサマリー自動生成

成果: レポート作成時間 週3時間 → 0時間(完全自動化)

AI予測分析の活用事例

1. 離脱予測とリテンション施策

活用方法: AIが顧客の行動パターンから離脱確率を予測

- 離脱確率70%以上 → 特別オファーメール自動送信

- 離脱確率50-70% → リテンション施策(ウェビナー招待等)

- 離脱確率30%以下 → 通常フォロー

成果: 離脱率 -25%、LTV +35%向上

2. CV数予測と目標達成施策

活用方法: 過去データから月末のCV数を予測

- 予測CV数が目標未達 → AIが追加施策を自動提案

- 広告予算の再配分提案

- リード育成の加速施策提案

成果: 目標達成率 65% → 92%に向上

AIデータ分析のROI計算

試算条件: マーケティング担当2名、月間広告費300万円

| 項目 | 導入前 | 導入後 |

|---|---|---|

| 分析工数 | 週8時間 | 週1時間 |

| 工数削減価値 | - | 月14万円(時給5,000円換算) |

| 広告ROAS改善 | 200% | 400%(+200%) |

| 売上増加 | 月600万円 | 月1,200万円(+600万円) |

| AIツールコスト | - | 月12万円 |

| 年間ROI | - | +7,368万円(ROI: 5,100%) |

あなたの企業のROIを無料で試算します

ROI試算を依頼する →まとめ

AIデータ分析マーケティングは、もはや「あれば便利」ではなく「必須の投資」です。

✅ AI導入チェックリスト

- □ GA4を正しく設定する

- □ データ取得を自動化する

- □ ChatGPT API連携を構築する

- □ 分析プロンプトを作成する

- □ レポート自動生成を設定する

- □ PDCAサイクルを週次化する