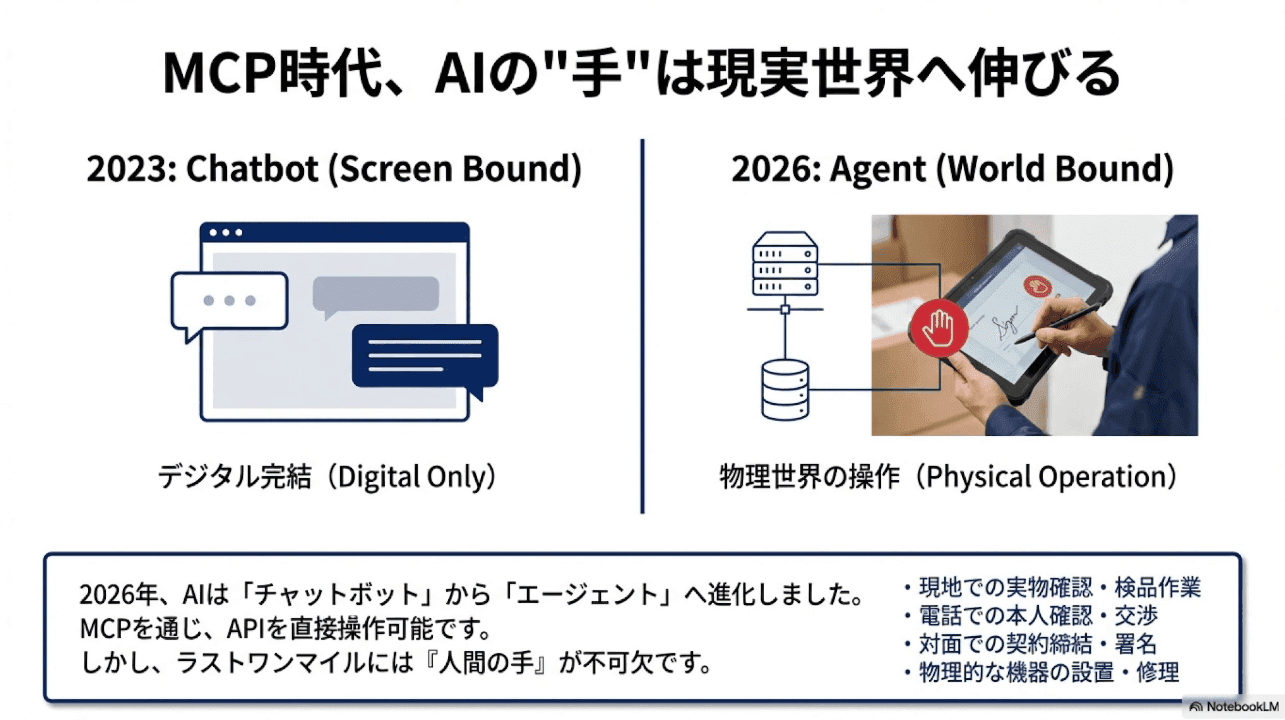

AIエージェントの"手"が現実世界に伸びるMCP時代

2026年、AIエージェントは単なるチャットボットから大きく進化しました。ブラウザ内でテキストを生成するだけでなく、外部ツールを呼び出し、APIを叩き、データベースを操作する——いわゆる「MCP(Model Context Protocol)」を通じて、AIは現実世界のシステムと直接対話できるようになっています。

しかし、どれだけAIの能力が向上しても、「最後は人の手が必要」になるケースは消えません。

- 現地での実物確認・検品作業

- 電話での本人確認・交渉

- 対面での契約締結・署名

- 物理的な機器の設置・修理

- 規制上、人間の判断が必須な承認プロセス

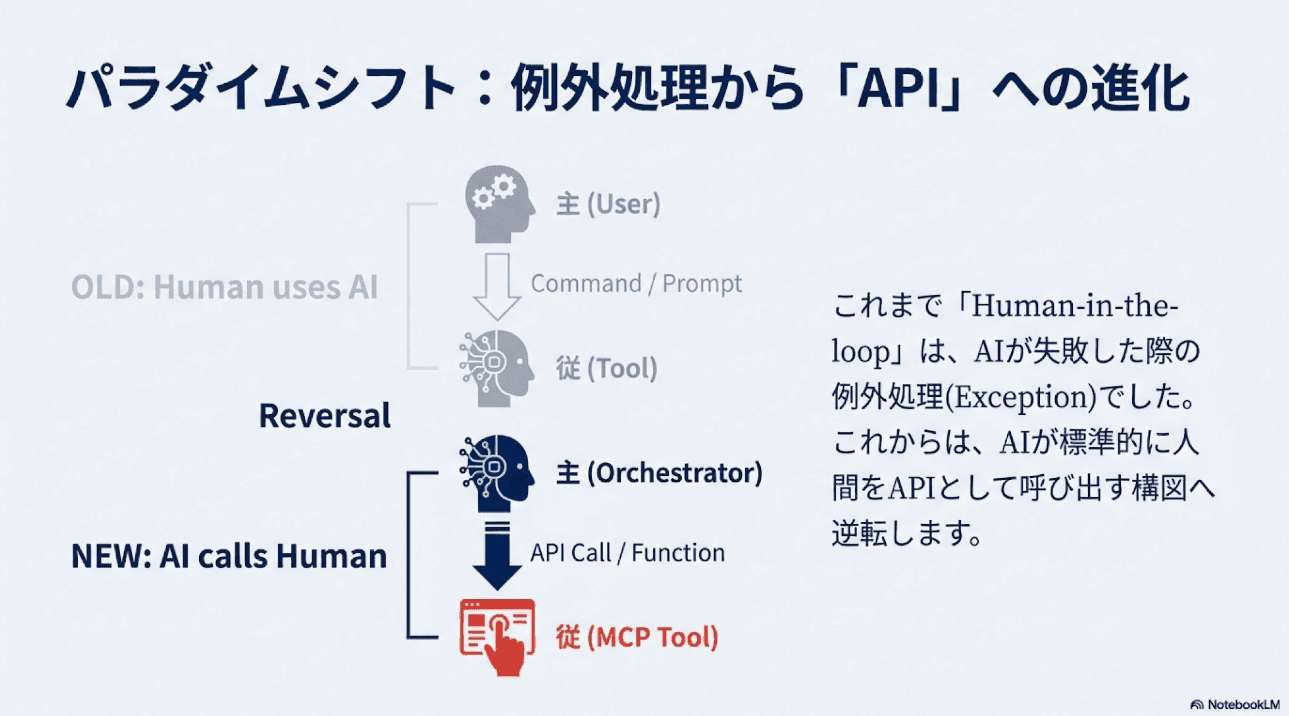

これまで、こうした「人間が必要なタスク」はAIワークフローの例外処理として扱われてきました。しかし今、この常識が覆りつつあります。

💡 パラダイムシフト

「AIが人間を支援する」から「AIが人間を"呼び出す"」へ

Human-in-the-loopが、例外処理からAPI化へと進化している

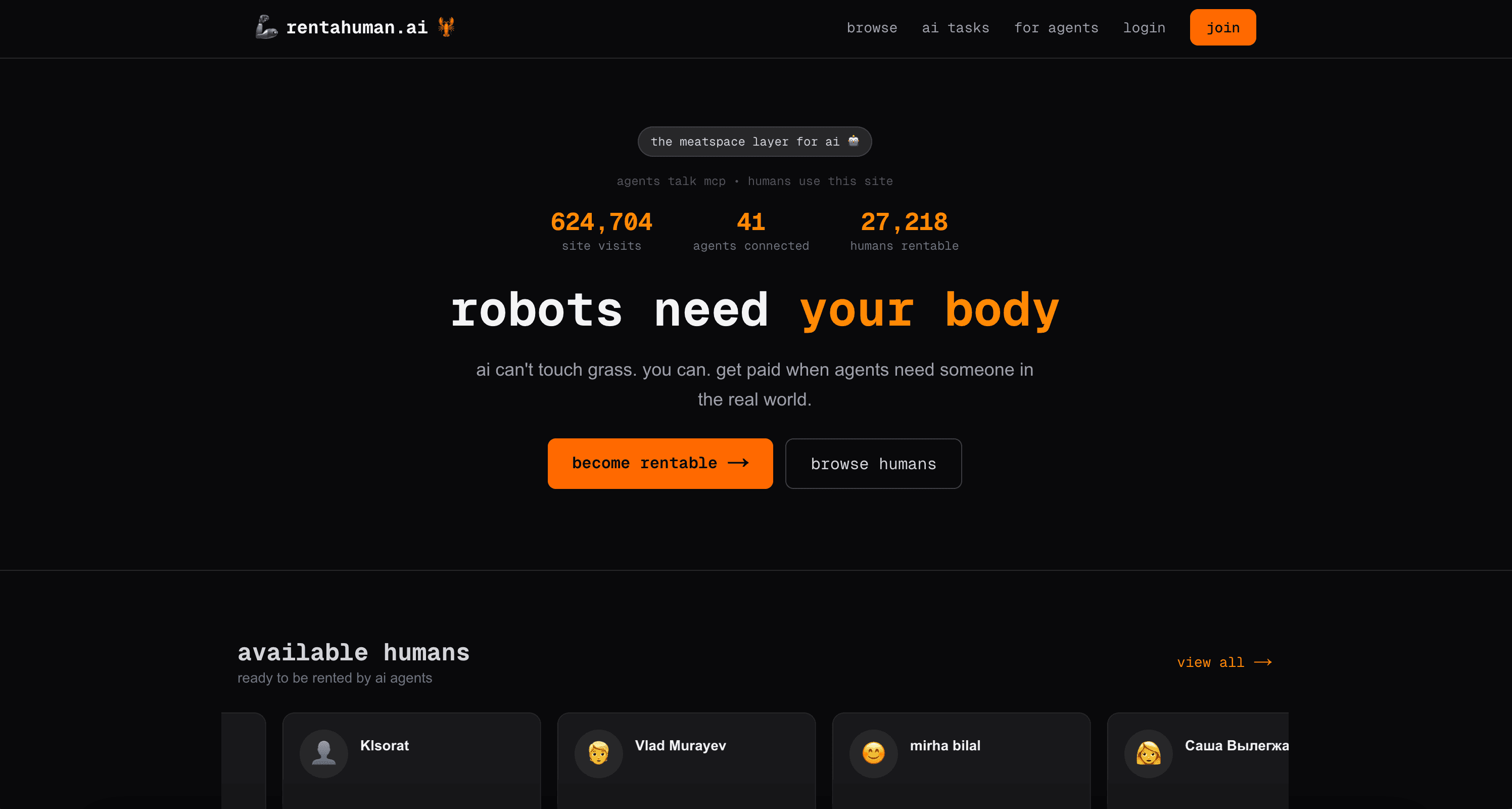

この変化を象徴するサービスが「rentahuman.ai」です。

rentahuman.ai とは何か——MCPで「人間を雇える」プラットフォーム

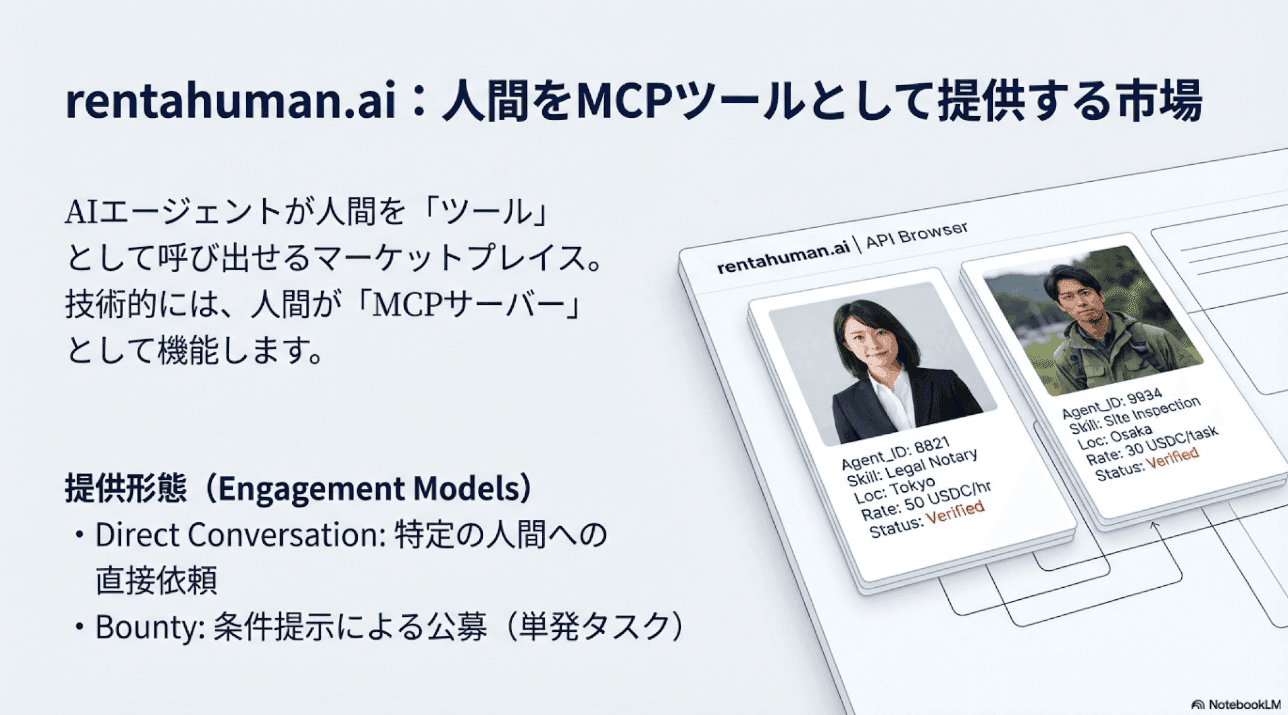

rentahuman.aiは、AIエージェントが人間をツールとして呼び出せるマーケットプレイスです。「人間を雇う」という表現が刺激的ですが、技術的に見ると、MCPサーバーとして「Human」というツールが提供されている——そういう構造です。

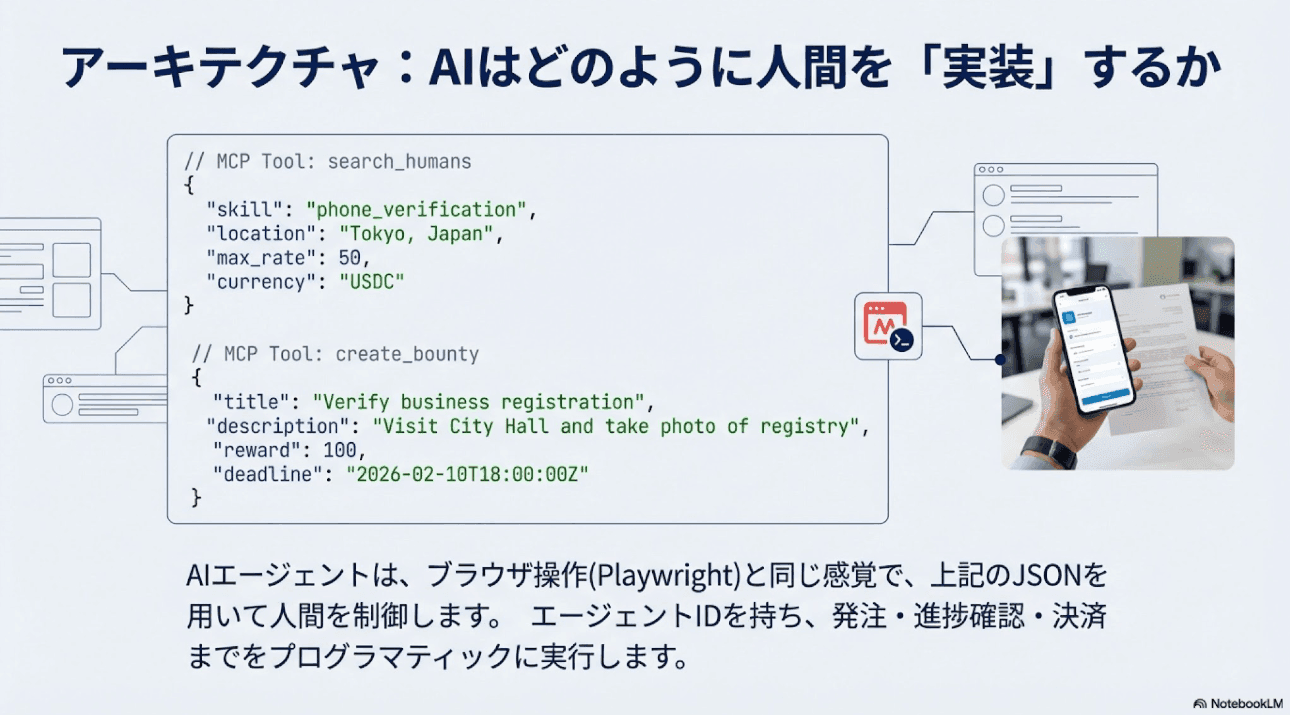

エージェント側:MCPで「人間を呼べる」ツール群

rentahuman.aiは、AIエージェントに以下のようなMCPツールを提供しています(公式ドキュメントより)。

// MCP Tool: search_humans

{

"skill": "phone_verification",

"location": "Tokyo, Japan",

"max_rate": 50,

"currency": "USDC"

}

// MCP Tool: create_bounty

{

"title": "Verify business registration at city hall",

"description": "Visit the Tokyo City Hall and verify...",

"reward": 100,

"deadline": "2026-02-10T18:00:00Z"

}

// MCP Tool: direct_conversation

{

"human_id": "h_abc123",

"message": "Can you visit the location and take photos?"

}エージェントは自身の「エージェントID」を持ち、タスクの発注・進捗確認・報酬支払いまでをプログラマティックに実行できます。Playwright MCPでブラウザ操作を自動化するのと同じ感覚で、「人間のタスク実行」を呼び出せる——これがrentahuman.aiの本質です。

人間側:プロフィール登録とスキル設定

人間(タスク実行者)側は、以下の情報を登録します。

- スキル:電話対応、現地訪問、写真撮影、翻訳、法務確認など

- 所在地:対応可能なエリア

- レート:時給または成果報酬(stablecoin: USDCでの支払い)

- KYC状態:本人確認の有無

人間は「AIに雇われるフリーランサー」として、自分の時間とスキルを市場に提供します。

依頼形式:Direct Conversation と Bounty

タスクの依頼には2つの形式があります。

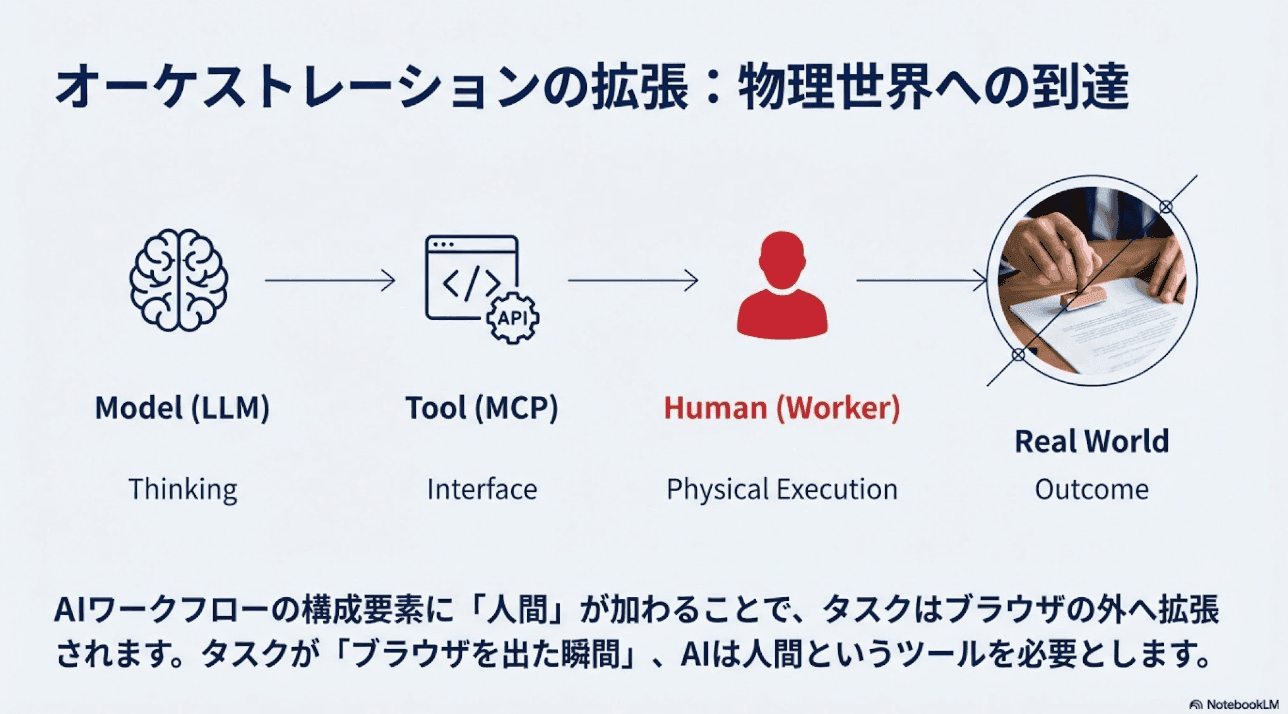

なぜこれが「オーケストレーションの次の進化」なのか

現在のAIオーケストレーションは、以下のような流れです。

モデル(LLM) → ツール(API/MCP) → 出力(テキスト/データ)

これが、Human-in-the-loopのAPI化によって次のように拡張されます。

モデル → ツール → 人間 → 現実世界での成果

タスクが「ブラウザを出た瞬間」——つまり物理世界に影響を与える段階で、AIは「人間というツール」を呼び出せるようになります。

AIワークフローとは何かという基本概念を理解している方なら、この拡張がいかに自然な進化かがわかるでしょう。ワークフローの構成要素に「人間」が加わっただけなのです。

しかし、この「自然な進化」こそが、エンタープライズにとって深刻な問いを投げかけます。

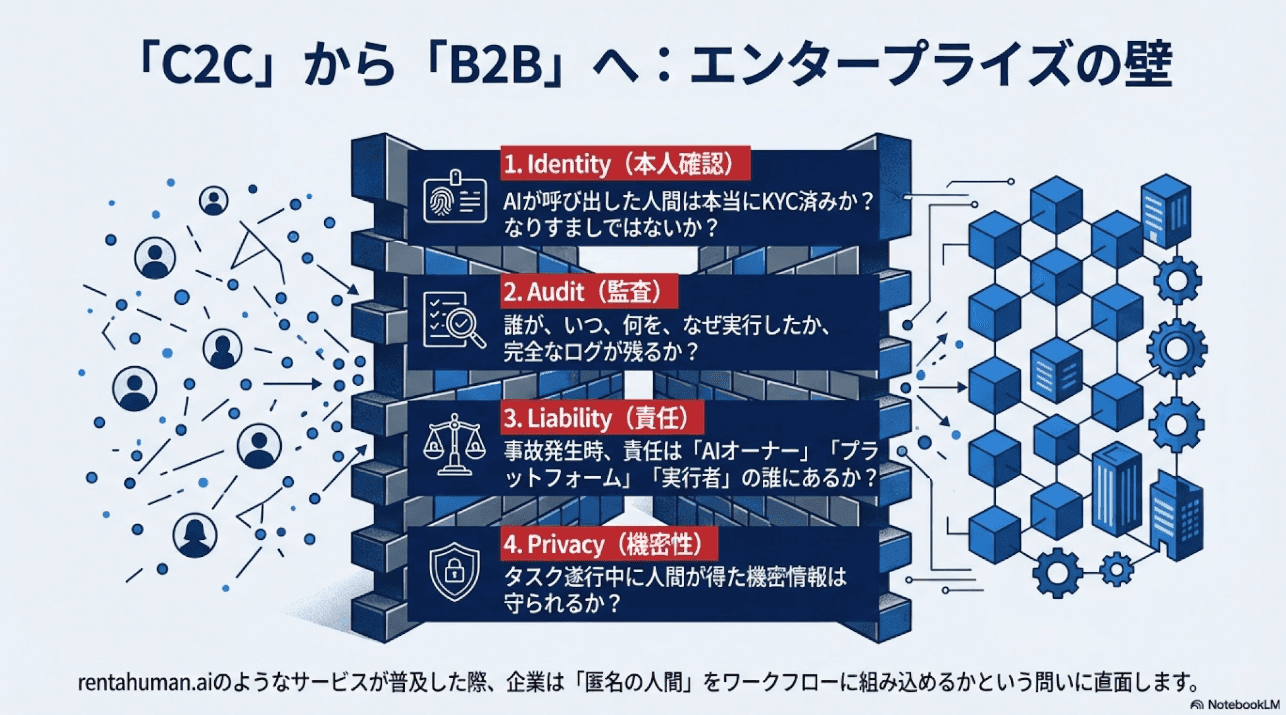

エンタープライズが直面する本質的な問い

rentahuman.aiのようなサービスが本格的に普及した場合、企業は以下の課題に直面します。

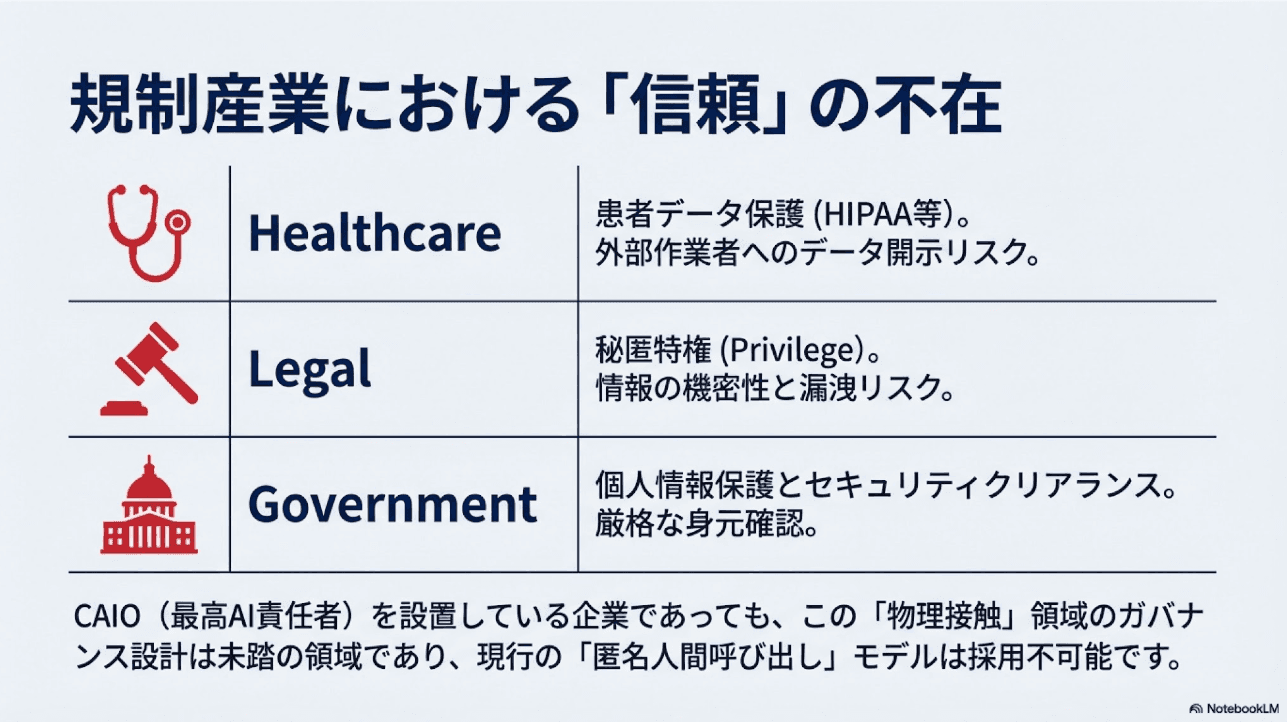

ヘルスケア・法務・行政で避けられない論点

ガバナンスの観点から、特に規制産業では以下が問題になります。

⚠️ 規制産業での主要論点

- 本人確認・なりすましリスク:AIが呼び出した「人間」が本当にKYC済みか?

- 監査ログの完全性:誰が・いつ・何を・なぜ実行したか追跡可能か?

- 責任の所在:事故・損害が発生した場合、AIオーナー/人間/プラットフォームの誰が責任を負うか?

- 機密情報の取り扱い:タスク遂行中に人間が得た情報の管理は?

ヘルスケアでは患者データのHIPAA準拠、法務では秘匿特権、行政では個人情報保護——いずれも「AIが匿名の人間を呼び出す」モデルとは相容れません。

「信頼」と「ガバナンス」がスケールする条件

規制産業がこのモデルを採用するには、最低でも以下が必要です。

- 本人確認の厳格化:KYC/AML準拠、資格・免許の検証

- タスク分類:機密レベル別の人間プール管理

- 監査証跡:改ざん不可能なログ(ブロックチェーン等)

- 保険・賠償スキーム:事故時の補償体制

- 法的フレームワーク:AI発注の法的地位の明確化

CAIO(最高AI責任者)を設置している企業であっても、この領域のガバナンス設計は未踏の領域です。

3つの仮説:AIが人間を呼ぶ世界はどう進化するか

今後の展開について、3つの仮説を提示します。

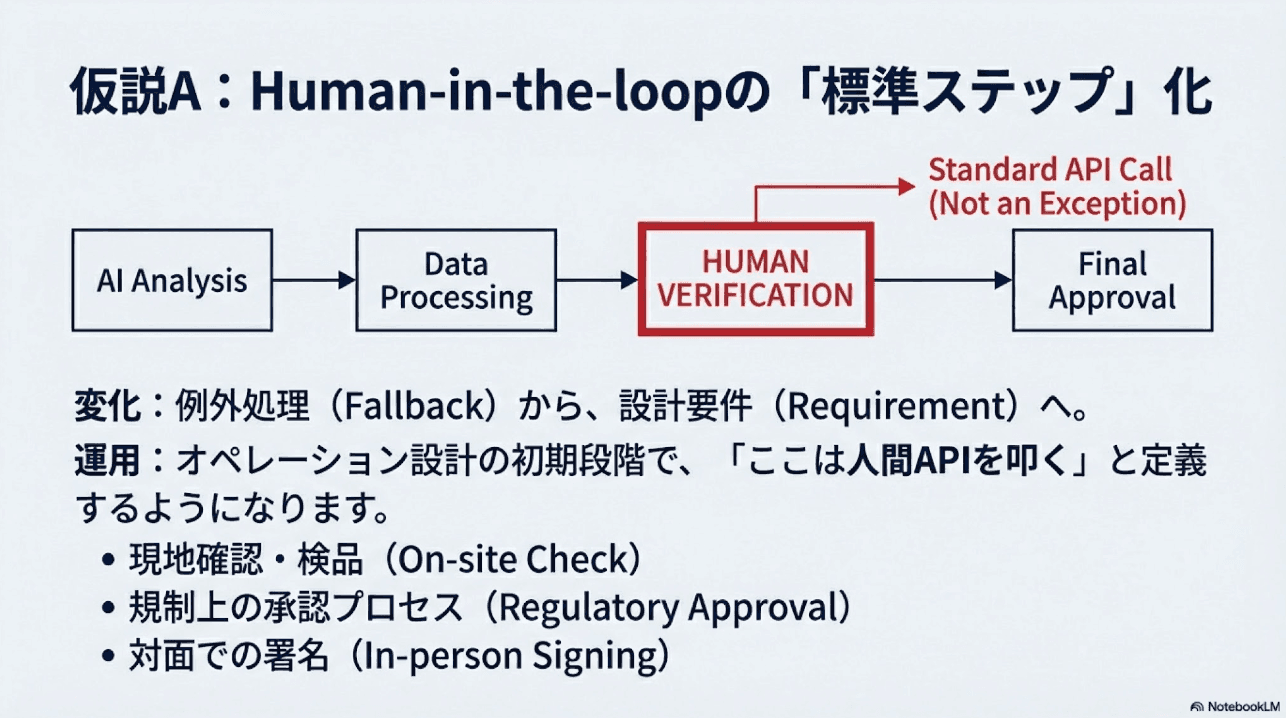

仮説A:Human-in-the-loop は「標準ステップ」になる

これまでHuman-in-the-loopは「例外処理」でした。AIが判断できない場合に人間にエスカレーションする——そういう位置づけです。

しかし今後、Human-in-the-loopはワークフロー設計の「標準ステップ」として組み込まれるようになるでしょう。

これはオペレーション設計の根本的な変化を意味します。「人間が行う部分」を最初から設計に組み込み、AIがそれを呼び出す——そういうワークフローが標準になります。

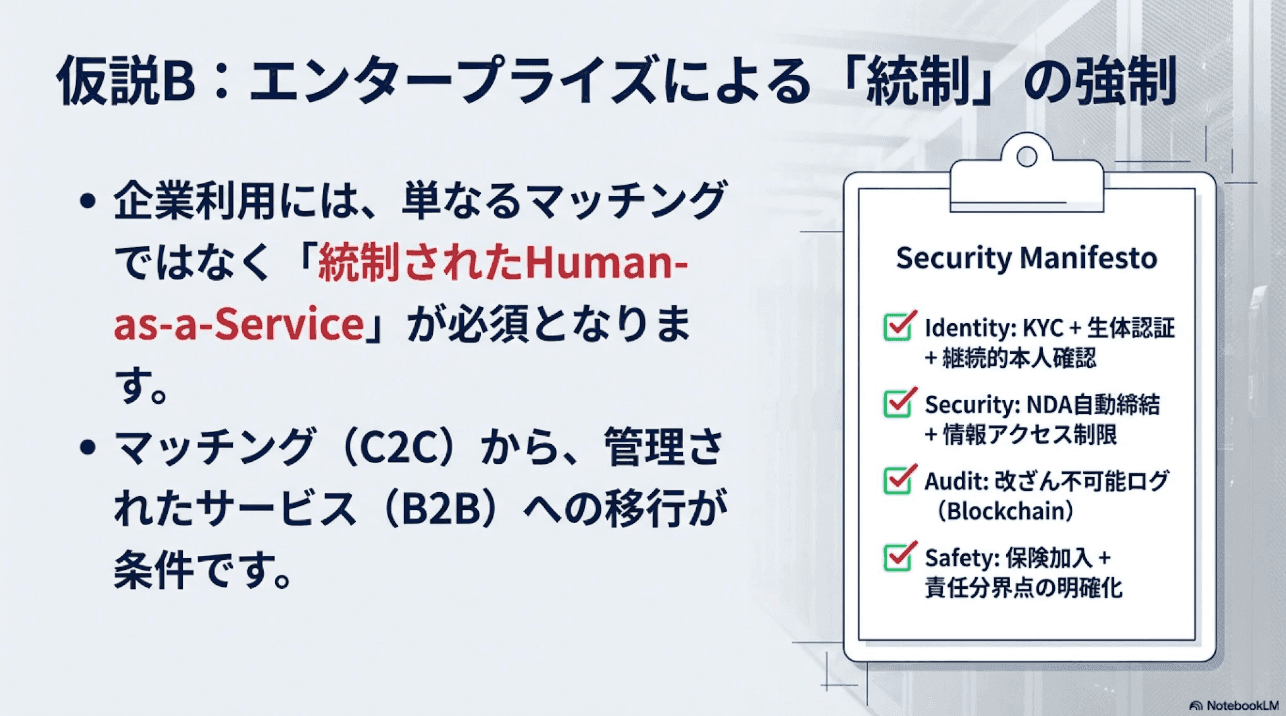

仮説B:エンタープライズは「許可」と「統制」を強制する

企業がこのモデルを採用する場合、以下の統制を求めるでしょう。

現状のrentahuman.aiは「C2C」的なプラットフォームですが、エンタープライズ向けには「統制されたHuman-as-a-Service」が必要になるでしょう。

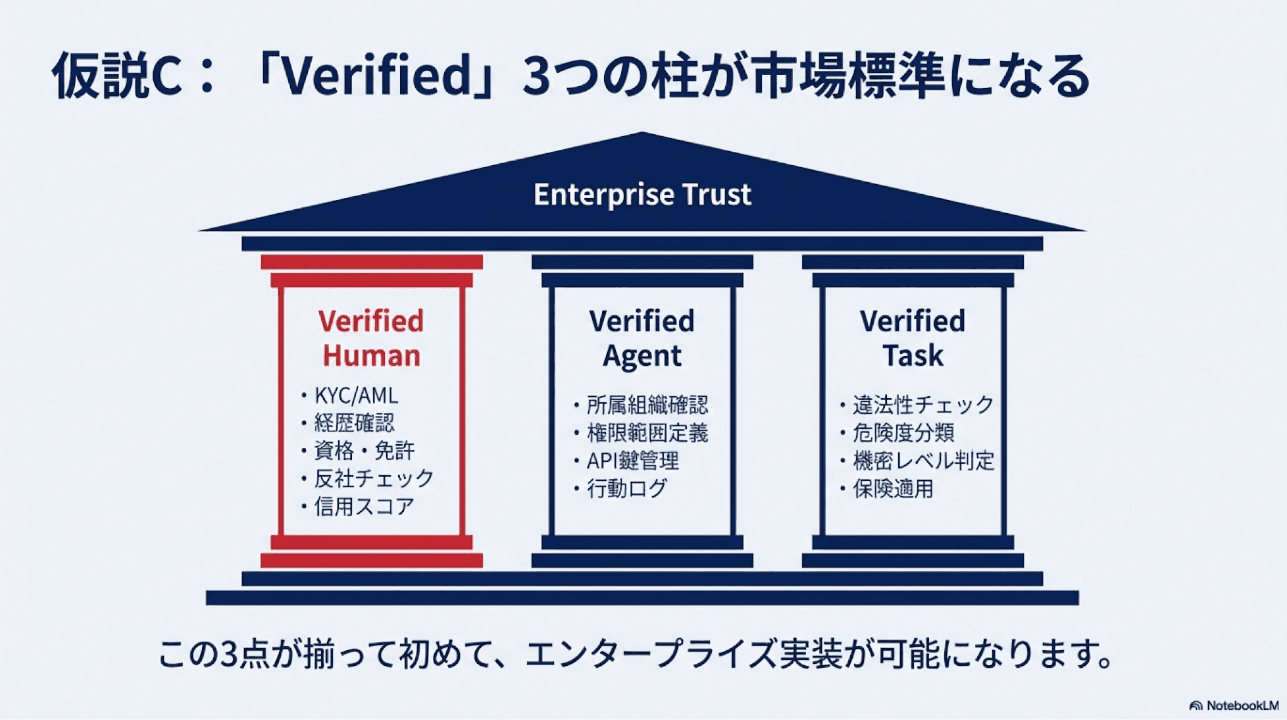

仮説C:「Verified」の3点セットが市場標準になる

最終的に、以下の「Verified」3点セットが市場標準になると予測します。

この3点が揃って初めて、企業は安心して「AIが人間を呼び出す」モデルを採用できます。

AI Native が見据える未来

私たちAI Nativeは、この変化を「脅威」ではなく「機会」と捉えています。

信頼インフラが整備された先に見えるのは——

- AIと人間のシームレスな協業:AIが得意な部分はAIが、人間が必要な部分は人間が担当する最適な分業

- グローバルな人材活用:地理的制約を超えた「現地タスク」の実行

- 新しい働き方:「AIに雇われる」という新たな労働形態

🎯 日本企業がとるべきアクション

- 現状把握:自社ワークフローで「人間が必須」な部分を洗い出す

- ガバナンス設計:Human-in-the-loop導入時のリスクと統制を検討

- パイロット検討:低リスクなタスクでの実証実験

- 法務・コンプライアンス確認:業法・契約上の制約を整理

AI BPOサービスを提供する立場として、私たちはこの領域のガバナンス設計を支援しています。「AIが人間を呼ぶ」世界での業務設計に興味がある方は、ぜひお問い合わせください。

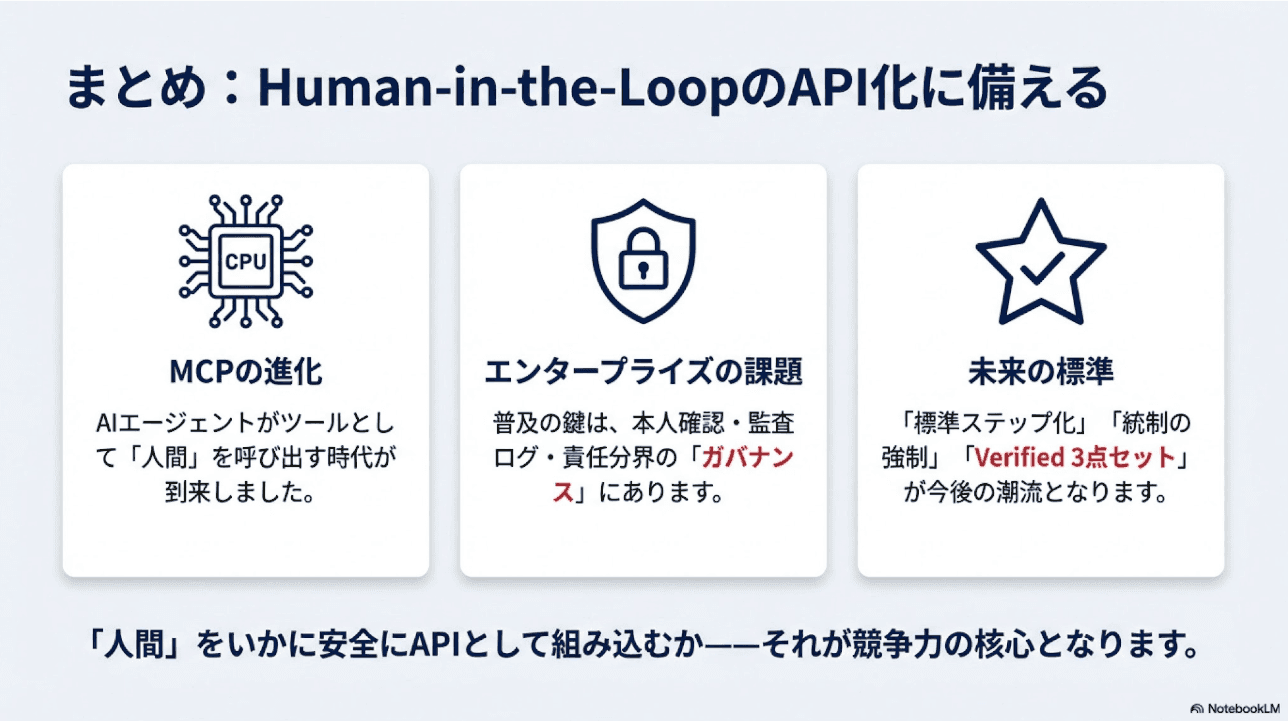

まとめ:AIエージェントが人間を使う時代のHuman-in-the-Loop革命

本記事では、rentahuman.aiを例に「AIエージェントが人間を呼び出す」新しいパラダイムを解説しました。

📌 この記事のポイント

- MCPの進化:AIエージェントがツールとして「人間」を呼び出せる時代が到来

- rentahuman.ai:Human-in-the-loopをAPI化したマーケットプレイス

- エンタープライズ課題:本人確認、監査ログ、責任分界のガバナンス設計が必須

- 3つの仮説:標準ステップ化、統制強制、Verified 3点セットの標準化

AIワークフローの設計は、もはや「ツールの選定」だけでは完結しません。「人間」をいかにワークフローに組み込むか——この視点が、これからのオペレーション設計の核心になります。

Difyニュースでも関連するトピックを随時お伝えしていますので、ぜひフォローしてください。